DeepSeek-R1 动态量化 1.58-bit:挑战开源推理极限

大家好!这里是 AI云涯⚡,专注为您解读前沿AI技术动态💡,追踪行业热点与开源突破📌!

作者:Unsloth Daniel & Michael

发布日期:2025年2月13日

原文出处:Unsloth - Open source Fine-tuning for LLMs

🌟 前言

近期,DeepSeek-R1 凭借媲美 OpenAI O1 模型的推理能力引发关注🚀,且以完全开源姿态强势登场!我们成功将其 6710 亿参数(671B) 的原始体积(~720GB)动态量化至 131GB,实现 80% 的惊人压缩率📉,同时保持高度可用性。

通过深度解析 DeepSeek R1 架构🔍,我们创新性地:

- 对部分层采用高精度量化(如 4bit)

- 将多数「MoE(混合专家)」层(类似 GPT-4 中的设计)压缩至 1.58bit⚙️

⚠️ 简单粗暴的全模型量化会导致模型崩溃(如无限循环/乱码输出),而动态量化策略完美规避了这一风险。

硬件需求

| 场景 | 配置要求 | 性能指标 |

|---|---|---|

| 高速推理 🚀 | 160GB VRAM(如 2x H100 80GB) | 吞吐量 140 tokens/秒 单用户推理 14 tokens/秒 |

| 最低配置 ⏳ | 20GB RAM(CPU) | 可运行但速度较慢 |

| 推荐配置 ✅ | VRAM + RAM 总和 ≥80GB | 平衡性能与资源占用 |

🦥 1. 动态量化版本概览

为了让更多小伙伴能在本地上顺利�跑起 DeepSeek-R1,Unsloth 官方特别提供了多个动态量化版本,从 131GB 到 212GB 不等;它们基于「分层量化」与「重要度矩阵」(importance matrix) 等方法,对模型中各部分(尤其是 MoE 层与 down_proj 模块)进行了精细量化,从而避免了简单粗暴量化带来的无限循环或生成无效输出等问题。

下面这张表即列出了 4 种核心动态量化规格:

| MoE位数 | 文件大小 | 类型 | 质量 | 下载链接 | down_proj |

|---|---|---|---|---|---|

| 1.58 | 131GB | IQ1_S | Fair | 链接 | 2.06/1.56bit |

| 1.73 | 158GB | IQ1_M | Good | 链接 | 2.06bit |

| 2.22 | 183GB | IQ2_XXS | Better | 链接 | 2.5/2.06bit |

| 2.51 | 212GB | Q2_K_XL | Best | 链接 | 3.5/2.5bit |

☝️ 如果你需要 4-bit、蒸馏版或其他量化形式,官方也提供了更全的 DeepSeek R1 版本合集 以供选择。

📊 2. 性能基准与对比

相较于常规基准测试,这里我们直接让各版本尝试「实现一个带多重随机要素的 Flappy Bird 游戏」并做 pass@3 测评。具体做法:

- 随机种子:选用 3407, 3408, 3409 进行多次生成。

- 评估标准:看是否能正确使用随机颜色、随机形状、是否能在 Python 解释器中运行等 10 个要点;将满足程度转换成分数。

- 对照:一部分版本做「动态量化」,一部分做「一刀切量化」。temperature固定为 0.6。

| DeepSeek Original | 1.58-bit Version |

|---|---|

|  |

我们惊讶地发现😲,即使经过 80% 的极致压缩,我们的动态 1.58bit 量化版本仍能生成有效输出✅!但若采用普通量化方法,后果将截然不同:

-

❌ 全模型粗暴量化测试结果

- 种子 3407 生成无限循环文本🌀:"Colours with dark..." 重复超 50 次

- 种子 3408 输出崩溃代码段💥:"Pygame's Pygame's..." 显示设置异常堆叠

- 即使将全模型量化至 1.75bit(149GB),虽停止循环却产生全黑屏输出🖤

-

📊 量化方案对比

方案 大小 关键缺陷 Flappy Bird 得分 全模型 1.58bit 133GB 完全失效(得分 0%) ❌ 动态 1.58bit 131GB 1/8000 token 偶发错误⚠️ 69.2% 🎯 全模型 1.75bit 149GB 性能较差 16.7% 📉 动态 1.73bit 158GB 无显著缺陷 90.8% 🎯 全模型 2.06bit 175GB 性能反降 61.7% 📉 推荐方案 2.22bit 183GB 无显著缺陷 91.7% 🏆

优化发现🔧:

- 动态量化中设置

min_p = 0.1可减少 90% 的偶发错误 - 全模型量化到 175GB 时得分(61.7%)竟�低于更小的动态版本(69.2%),证明动态策略优势

- 最终选择建议:

- 优先 2.22bit 版本:追求性能首选(需 183GB)

- 慎用 1.58bit 动态版:资源受限时可选,需搭配容错机制

💡 核心结论:动态量化通过智能分层压缩策略⚙️,在 131GB 极小体积下仍保持可用性,而传统量化方案则面临精度悬崖⛰️。

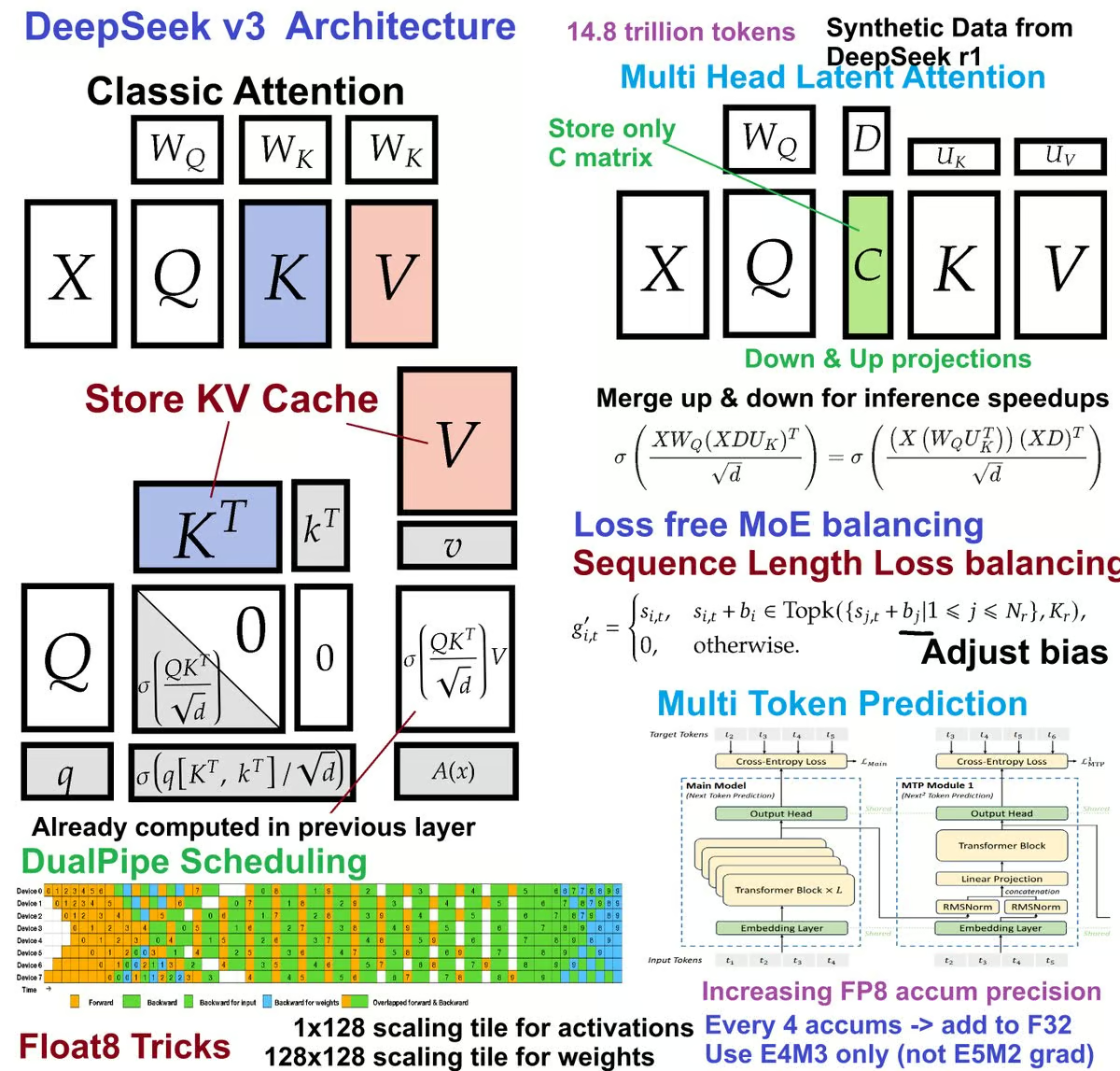

🐋 3. 解密 DeepSeek R1 架构

在我们 先前对 DeepSeek V3 模型的分析 中(该模型使用 DeepSeek R1 进行合成数据生成),我们发现其前3层为全密集层(非 MoE 结构)🔍。这里简单回顾 MoE(混合专家)层的魔力:它通过动态屏蔽大部分参数为 0 的条目✨,实现在不增加计算量(FLOPs)的前提下扩展模型参数量🚀。

MoE 的终极目标是 "欺骗"the scaling laws🎭——通过增加参数量而不改变计算成本。关于 MoE 的最新进展,可参考这篇讨论Memory Layers 新方法的推文

🔧我们结合以下前沿研究实现突破:

🛠 量化策略实现

-

前 3 密集层处理

- 仅占权重 0.5% ➡️ 保留为 4/6bit

- "如同保护精密仪器的核心电路" 🔭

-

MoE 共享专家层

- 占权重 1.5% ➡️ 采用 6bit 量化

- 动态路由机制保障专家激活效率 ⚡

-

注意力模块优化

- MLA 注意力模块(低于5% 权重)保留 4/6bit

- 注意力输出(3%)建议保持高精度⚠️

-

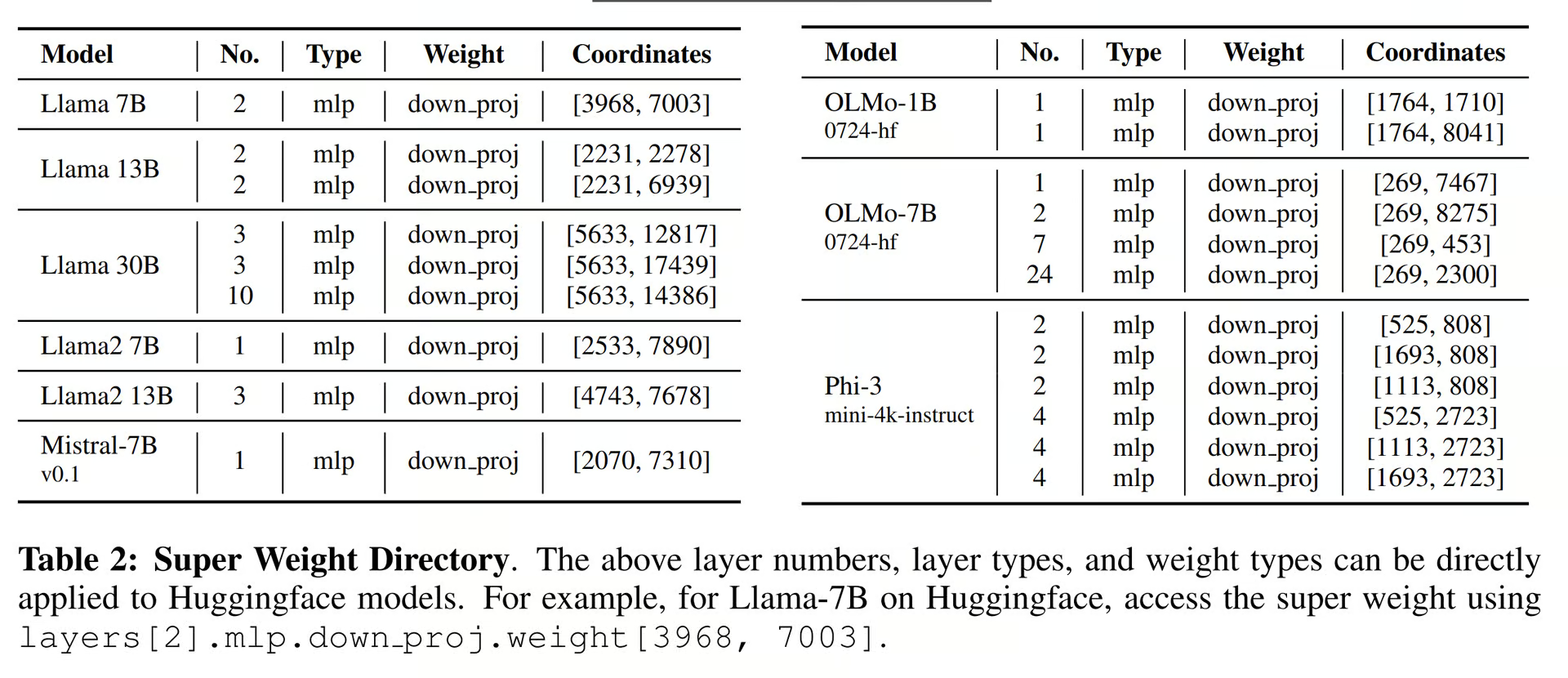

关键敏感层发现 🔥

- down_proj 层对量化极度敏感(尤其前 3-6 层)。与 Super Weights paper 结论一致:几乎所有不应量化的权重都在 down_proj 中

- SwiGLU 激活函数导致数值放大效应📈:

上投影和栅极投影本质上是相乘形成更大的数字,而下投影必须将它们缩小——粗暴量化将引发雪崩式误差 💥 🎯

- down_proj 层对量化极度敏感(尤其前 3-6 层)。与 Super Weights paper 结论一致:几乎所有不应量化的权重都在 down_proj 中

-

其他组件策略

组件 量化方案 说明 词嵌入层 4bit 🌌 基础语义保留 语言模型头 6bit 🧩 输出精度保障 MoE 路由器 32bit 🛡️ 路由决策需高可靠性 层归一化 32bit ⚖️ 数值稳定性关键 -

量化成果爆发 🚀

- 88% MoE 权重成功压缩至 1.58bit

- 模型体积实现 720GB → 131GB 的史诗级压缩 📉

-

开源实践 💻

- 完整代码已发布至 unslothai/llama.cpp

-

集成动态量化

- 集成动态量化+重要性矩阵(借鉴 Bartowski)🧪

💡 工程智慧:通过精准手术刀式量化⚕️,在庞杂的模型架构中锁定关键层,实现性能与压缩的完美平衡!

💬 4. 聊天模板问题解析

📝 统一模板结构

所有蒸馏版本与主 671B R1 模型均采用相同对话模板:

<|begin▁of▁sentence|><|User|>What is 1+1?<|Assistant|>It's 2.<|end▁of▁sentence|><|User|>Explain more!<|Assistant|>

⚠️ 关键处理逻辑

- 系统强制添加 BOS(起始符),对话轮次由 EOS(结束符)分隔

- 推理时需调用:

tokenizer.encode(..., add_special_tokens=False) # 防止双BOS符 - llama.cpp/GGUF 推理需手动跳过BOS(框架自动添加)

🔢 分词器ID映射表

<|User|>What is 1+1?<|Assistant|>

<think> 和 </think> 令牌有自己的指定令牌。 在 Qwen 和 Llama 的精简版本中,一些标记被重新映射,例如 Qwen 没有 BOS 标记,因此必须使用 <|object_ref_start|> 代替。

🌐 各版本特殊令牌对照

| Token | R1 | 蒸馏-Qwen | 蒸馏-Llama |

|---|---|---|---|

<think> | 128798 | 151648 | 128013 |

</think> | 128799 | 151649 | 128014 |

<|begin▁of▁sentence|> | 0 | 151646 | 128000 |

<|end▁of▁sentence|> | 1 | 151643 | 128001 |

<|User|> | 128803 | 151644 | 128011 |

<|Assistant|> | 128804 | 151645 | 128012 |

| 填充令牌 | 2 | 151654 | 128004 |

🔍 原始模型特殊令牌对照

| Token | Qwen 2.5 32B Base | Llama 3.3 70B Instruct |

|---|---|---|

<think> | <|box_start|> | <|reserved_special_token_5|> |

</think> | <|box_end|> | <|reserved_special_token_6|> |

<|begin▁of▁sentence|> | <|object_ref_start|> | <|begin_of_text|> |

<|end▁of▁sentence|> | <|endoftext|> | <|end_of_text|> |

<|User|> | <|im_start|> | <|reserved_special_token_3|> |

<|Assistant|> | <|im_end|> | <|reserved_special_token_4|> |

| 填充令牌 | <|vision_pad|> | <|finetune_right_pad_id|> |

🚨 原始错误配置

- 错误使用 EOS令牌(如R1的

<|end▁of▁sentence|>)作为填充令牌 - 引发无限生成:框架通常将EOS标记为-100

🛠️ 修复方案

| 版本 | 新填充令牌 | 特性说明 |

|---|---|---|

| Qwen蒸馏版 | <|vision_pad|> | 视觉任务专用填充符 👁️ |

| Llama蒸馏版 | <|finetune_right_pad_id|> | 微调对齐专用 🦙 |

| R1原版 | 使用<|▁pad▁|>或新增<|PAD▁TOKEN|> | 专用填充令牌 🆕 |

💡 使用建议

1️⃣ 配置验证

print(tokenizer.special_tokens_map) # 验证特殊令牌映射

2️⃣ 框架适配

- 🤖 Transformers:注意

add_special_tokens参数 - 🦙 llama.cpp:自动添加BOS需特殊处理

3️⃣ 微调注意事项

- 确保

<think></think>逻辑块完整 - 避免将EOS令牌用于padding_mask计算

该修复已同步至所有模型版本,彻底解决生成异常问题!🎉

🖥️ 5. 运行动态R1量化模型

⚠️ 关键处理逻辑

- 所有系统(如Ollama/OpenWebUI/Transformers)均可运行GGUF格式的动态量化模型

- 显存不足时推理速度会下降,但功能正常

🔧 环境准备

llama.cpp编译指南

apt-get update

apt-get install build-essential cmake curl libcurl4-openssl-dev -y

git clone https://github.com/ggerganov/llama.cpp

cmake llama.cpp -B llama.cpp/build \

-DBUILD_SHARED_LIBS=OFF -DGGML_CUDA=ON -DLLAMA_CURL=ON

cmake --build llama.cpp/build --config Release -j --clean-first --target llama-quantize llama-cli llama-gguf-split

cp llama.cpp/build/bin/llama-* llama.cpp

📥 模型下载

# pip install huggingface_hub hf_transfer

# import os # Optional for faster downloading

# os.environ["HF_HUB_ENABLE_HF_TRANSFER"] = "1"

from huggingface_hub import snapshot_download

snapshot_download(

repo_id = "unsloth/DeepSeek-R1-GGUF",

local_dir = "DeepSeek-R1-GGUF",

allow_patterns = ["*UD-IQ1_S*"],

)

🧮 GPU层数计算

卸载公式

DeepSeek R1 有 61 层。 例如,如果使用 24GB GPU 或 80GB GPU,四舍五入后就可以卸载(如果内存不足,则减少 1):

推荐配置表

| 量化精度 | 文件大小 | 24GB GPU | 80GB GPU | 双80GB GPU |

|---|---|---|---|---|

| 1.58bit | 131GB | 7层 | 33层 | 全层61 |

| 1.73bit | 158GB | 5层 | 26层 | 57层 |

| 2.22bit | 183GB | 4层 | 22层 | 49层 |

| 2.51bit | 212GB | 2层 | 19层 | 32层 |

⚙️ 模型运行配置

量化策略

- K缓存量化:使用4bit精度量化

- V缓存要求:需编译llama.cpp的flash attention内核

运行参数

- 线程使用:自动调用机器全部CPU核心

- 温度设置:采用DeepSeek推荐值0.6

- 上下文长度:通过

--ctx-size指定生成token数

📂 目录结构

主目录/

├── llama.cpp/ # 编译后的llama.cpp工具集

└── DeepSeek-R1-GGUF/ # 下载的量化模型文件

🔧 核心参数解析

| 参数 | 说明 |

|---|---|

--threads | 使用的CPU核心数(与物理核心数一致) |

--ctx-size | 控制输出内容的上下文长度(token数) |

--n-gpu-layers | 卸载到GPU的层数(参考上方配置表) |

💡 技巧:可通过

nproc命令查询CPU核心数,例如nproc --all显示全部核心数

🚀 推理示例

RTX 4090 24GB配置

./llama.cpp/llama-cli \

--model DeepSeek-R1-GGUF/DeepSeek-R1-UD-IQ1_S/DeepSeek-R1-UD-IQ1_S-00001-of-00003.gguf \

--cache-type-k q4_0 \

--threads 16 \

--prio 2 \

--temp 0.6 \

--ctx-size 8192 \

--seed 3407 \

--n-gpu-layers 7 \

-no-cnv \

--prompt "<|User|>Create a Flappy Bird game in Python.<|Assistant|>"

🍎 6. Mac设备运行

M系列芯片128GB配置

对于 Apple Metal 设备,要注意 --n-gpu-layers 的使用。 如果发现机器内存不足,请减少内存。 对于 128GB 统一内存的机器,应该可以卸载 59 层左右。

./llama.cpp/llama-cli \

--model DeepSeek-R1-GGUF/DeepSeek-R1-UD-IQ1_S/DeepSeek-R1-UD-IQ1_S-00001-of-00003.gguf \

--cache-type-k q4_0 \

--threads 16 \

--prio 2 \

--temp 0.6 \

--ctx-size 8192 \

--seed 3407 \

--n-gpu-layers 59 \

-no-cnv \

--prompt "<|User|>Create a Flappy Bird game in Python.<|Assistant|>"

🦙 7. Ollama/Open WebUI集成

- 合并GGUF分片文件:

./llama.cpp/llama-gguf-split --merge \

DeepSeek-R1-GGUF/DeepSeek-R1-UD-IQ1_S/DeepSeek-R1-UD-IQ1_S-00001-of-00003.gguf \

merged_file.gguf

- 参考OpenWebUI官方教程进行部署

💡 注意:DeepSeek R1共61层,建议保留4层缓冲避免OOM。温度参数推荐设为0.6保持最佳生成效果。

💡 8. 提示与生成结果

完整提示词

Create a Flappy Bird game in Python. You must include these things:

1.You must use pygame.

2.The background color should be randomly chosen and is a light shade. Start with a light blue color.

3.Pressing SPACE multiple times will accelerate the bird.

4.The bird's shape should be randomly chosen as a square, circle or triangle. The color should be randomly chosen as a dark color.

5.Place on the bottom some land colored as dark brown or yellow chosen randomly.

6.Make a score shown on the top right side. Increment if you pass pipes and don't hit them.

7.Make randomly spaced pipes with enough space. Color them randomly as dark green or light brown or a dark gray shade.

8.When you lose, show the best score. Make the text inside the screen. Pressing q or Esc will quit the game. Restarting is pressing SPACE again.

The final game should be inside a markdown section in Python. Check your code for errors and fix them before the final markdown section.

📊 完整结果

所有18个生成结果与Python代码已上传至:

docs.unsloth.ai/basics/deepseek-r1-dynamic-1.58-bit

��💡 提示:文档包含完整的测试用例对比表和不同量化版本的性能指标